Künstliche Intelligenz als Verhaltensforscher

Computeralgorithmen zerlegen Beutefangverhalten von Zebrafischen in seine Komponenten

Was haben eine Tasse Tee aufgießen und Schuhe anziehen gemeinsam? Beide Aktionen bestehen aus mehreren, aneinandergereihten Bewegungen. „Sehr viele Verhalten setzen sich aus solchen Einzelmodulen zusammen – ähnlich wie aus Silben Sätze einer Sprache entstehen“, erklärt Duncan Mearns. „Um zu verstehen, wie ein Verhalten im Kopf entsteht, müssen wir die "Silben", also die Komponenten des Verhaltens kennen.“ Mit Hilfe künstlicher Intelligenz haben Mearns und seine Kollegen vom Max-Planck-Institut für Neurobiologie das Jagdverhalten von Zebrafischlarven in seine Komponenten zerlegt und gezeigt, wie sich daraus längere Sequenzen ergeben.

Weniger als einen halben Zentimeter lang, besitzen junge Zebrafische doch bereits alle Verhaltensweisen um zu überleben. Jagen ist solch ein angeborener Verhaltensablauf, den Erfahrung verfeinert. Doch wie steuern und kombinieren neuronale Schaltkreise die Verhaltenskomponenten, damit der Beutefang gelingt?

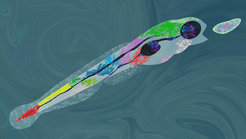

Um das Fischverhalten zu verstehen, haben die Neurobiologen aus der Abteilung von Herwig Baier eine Hightech-Messanlage entwickelt. Während sich die jungen Fische in einer kleinen Schale frei bewegen, erfassen Hochgeschwindigkeitskameras ihre Augen-, Schwanz- und Kieferbewegungen. Speziell entworfene Computeralgorithmen werten die erfassten Bilder aus und ordnen sie einer erlernten Verhaltenskomponente zu. Die Ergebnisse tausender Fischbewegungen zeigen drei Komponenten des Beuteschwimmzugs: Orientieren, Annähern und Erbeuten.

Die Bewegungen des Fischschwanzes werden, je nach Position der Beute, kontinuierlich moduliert. Trotzdem konnten die Computeralgorithmen drei definierte Bewegungsmuster für die drei Beutefang-Komponenten erkennen. Diese Bewegungsmuster liefen dann immer in der gleichen, stereotypen Reihenfolge nacheinander ab. „Das ist für unser Auge viel zu schnell und selbst verlangsamt könnten wir die Verhaltenskomponenten nicht so sauber voneinander trennen wie die Algorithmen“, erklärt Duncan Mearns, der die Messanlage mit Kollegen im Rahmen seiner Doktorarbeit entwickelt hat. Sogar wenn die Beute bereits vor dem Fischmaul ist, konnte der Computer zwei unterschiedliche Bewegungsarten ausmachen.

Die Beute stets im Blick

Die Untersuchungen haben belegt, dass die Fische ihre Beute mit beiden Augen anpeilen müssen, um das richtige Fangverhalten auswählen zu können. Je nach abgeschätzter Entfernung entscheiden sie sich dann für einen schnellen Sprint mit Zuschnappen oder einer tiefen Einsaugbewegung. Dank dieser Ergebnisse wissen die Forscher nun, dass sie zu diesem Zeitpunkt auch nach Nervenzellen auf beiden Seiten des Gehirns suchen müssen, die zur Berechnung von Entfernungen aktiv werden.

Als die Neurobiologen die Beute durch einen virtuellen Punkt ersetzten, erhielten sie auch Hinweise auf die Reizverarbeitung während des Beutefangs. Verschwand der virtuelle Beutepunkt – egal zu welchem Zeitpunkt – brachen die Fische ihr Jagdverhalten sofort ab. „Das zeigt uns, dass die Fische ein kontinuierliches Feedback der Augen zur Beute brauchen, um die gesamte Jagdsequenz abrufen zu können“, so Mearns.

Verhaltenssuche im Gehirn

Mit ihrem Versuchsaufbau haben die Neurobiologen ein komplexes Verhalten in einzelne, vom Computer gut zu unterscheidende Komponenten zerlegt. Dass es sich dabei um ein Verhalten des Zebrafisches handelt, ist kein Zufall: In den durchsichtigen Fischlarven können die Forscher nun mit Hilfe genetischer und optogenetischer Methoden gezielt nach den entsprechenden Nervenzellschaltkreisen für die beschriebenen Verhaltenskomponenten zu suchen. „Wir wissen jetzt viel besser, wonach wir suchen müssen und wo wir es finden könnten“, freut sich Mearns.